AI・ロボティクス技術を活用したスマートファクトリー化の推進

先進プロセス開発部 伊藤 亮

素形材開発部 小松 和三

技術の背景

人工知能(AI)技術は2006年にディープラーニングが誕生して以降続いている第3次ブームの中、これまで様々なフレームワークが提供されており容易に導入可能になってきています。中でもオープンソースとして開発者に無償で提供されるものを活用することで非常に低コストにAI技術を様々なアプリケーションに応用することができます。当センターではこれらの技術に関して、県内企業が自社内で技術者を育て、技術・ノウハウを蓄積しながら次々と新しい取組みに応用し、スマートファクトリー化を推進していくことが重要と考え、その支援を行うために必要なロボティクスのコア技術としてAIの効率的な学習方法の研究、およびロボットとAIを組み合わせたスマートロボティクス技術の開発を進めています。今回、オートエンコーダーを応用したAIの学習方法に関する取組みとロボットハンド開発に関する取組みを紹介します。

AIの開発環境、オープンソースの活用

ディープラーニングの実施例について示します。ここでは開発プラットフォームとしてはNeural Network Console (NNC)[1] およびTensorFlow2(Keras)、計算リソースとしてはローカルのPCではNVIDIA社製グラフィックボード(RTX2070Super)、大規模な計算を要する場合はABCI (AI Bridging Cloud Infrastructure、国立研究開発法人 産業総合研究所が構築・運用)を使用しました。

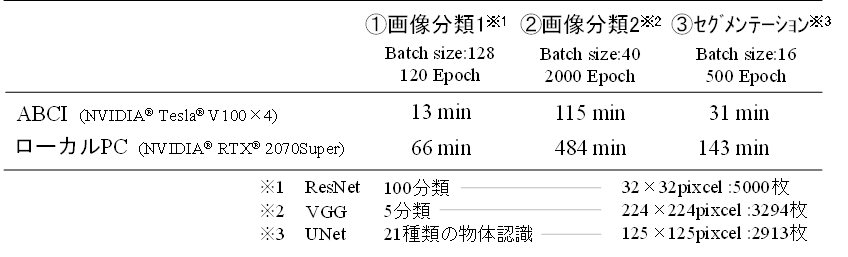

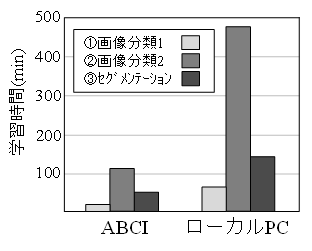

一例としてNNCを用いてResNet[2]に5000枚・100分類の画像を120エポック(学習回数)まで学習させる場合(画像分類1)、VGG[3]に3294枚・5分類のオリジナル画像を2000エポックまで学習させる場合(画像分類2)、UNet[4]に2913枚の画像とそれに対応する21種類の物体のピクセル毎のラベル情報を500エポックまで学習させる場合(セグメンテーション)の3つを実施した結果を表1および図1に示します。ABCIを使用した場合はローカルのPCを使用した場合と比較し概ね4~5倍の学習速度があることが確認できました。AI開発においてはネットワーク構造や学習データを模索しながらトライ&エラーを繰り返す必要があるため、学習速度は開発速度に直結します。今後の開発ではこの結果を踏まえ、学習データの大きさや必要な学習回数、ABCIの使用料等を鑑みて計算リソースをうまく使い分けていくことが重要と考えられます。

|

表1 ネットワークの種類と学習時間および学習データ |

|

|

|

|

|

図1 学習時間の比較 |

効率的なAIの学習方法に関する取組み

|

|

|

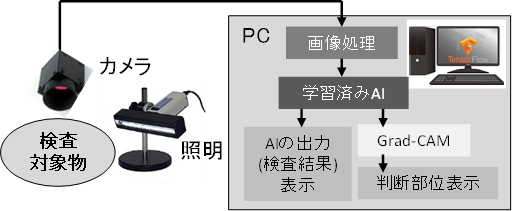

図2 AIを導入したシステム事例の概略 |

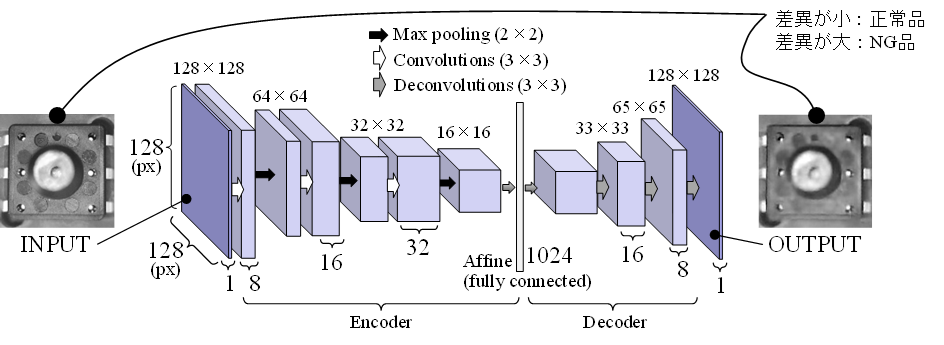

AIの導入にあたっての課題として、学習データの取得・前処理(アノテーション作業)に非常に時間・労力を有するという点が挙げられます。これに対し、3D計測技術やオートエンコーダー、GANといった技術を用いてアノテーションを効率化する手法について研究しています。AIを用いた良否判定では通常図2に示すように学習済みのAIに画像を入力すると正常かNGかを出力するシステムが一般的ですが、正常品の画像に加えて様々な種類のNG品の画像をそれぞれ大量に準備する必要があります。これに対し、オートエンコーダーを応用することによって良品の画像のみで電子部品の良否判定を実現したものを図3に示します。オートエンコーダーは、図に示すようにエンコーダ層とデコーダ層からなり入力画像の情報を一旦圧縮してから復元する構成となっており、学習させた画像はうまく復元できますが学習させていない画像は復元できないという特徴を持っています。よって正常品画像のみを学習させることで、NG品画像が入力されたら入力と出力の画像に差異が生じ、この差分を数値化することで良否判定を行うことが可能になります。

|

|

|

図3 オートエンコーダーを応用した画像検査の事例 |

ロボットハンド開発に関する取組み

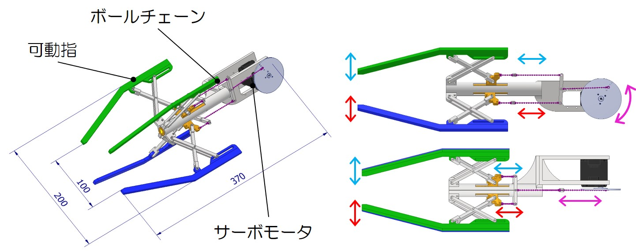

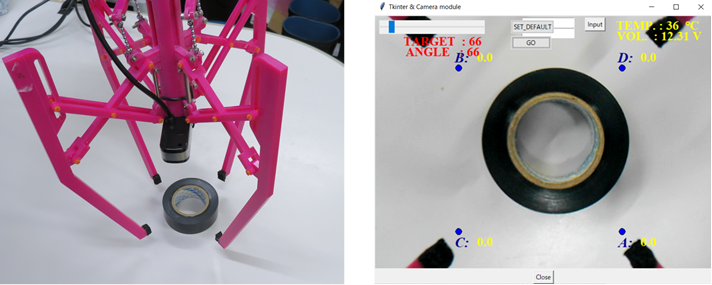

柔軟(軽量)で一つ一つ形状の異なる物体を傷付けずに把持することができるロボットハンドの例として設計・試作したものを図4に示します。4つの可動指は互いに独立した動作が可能な自由度を持っていますが、1つのサーボモータのみですべての指が協調して動作するようにリンク機構で接続していす。また、対象物を把持する際、リンク機構によって4指にかかる力がある程度均等に分配されるため、対象物は4指の中央部にある必要がなくなり、動作の制御は非常に容易となっています。3D樹脂プリンタを用いて各パーツを造形して組み立て、さらに画像処理用にカメラを装着したロボットハンドを図5に示します。このロボットハンドを用いた把持試験の様子を図6に示します。図6右は装着したカメラの画像であり、この画像をもとにAI等により把持の強さなどを制御する研究を行っているほか、4指の先端に圧力センサを装着して把持力をモニタリングしながら最適な把持を行う方法などの実験を行っています。

|

|

|

|

図4 設計したロボットハンドと駆動原理 |

図5 3D樹脂プリンタにより造形したロボットハンド |

|

|

|

図6 異形状対象物の把持試験 |

技術普及・人材育成

ここでご紹介したロボティクス技術について、産業技術センターで実施している「次世代ものづくり高度技術者育成事業」や共同研究などを通じて技術普及を行うことに努めております。様々なニーズにお応えしたいと考えておりますので、お気軽にご相談ください。

参考文献

[1] 小林由幸:“Deep Learningの活用を加速するNeural Network Console”,医用画像情報学会雑誌, Vol.37, No.1 (2020), pp.1-4.

[2] Kaiming He, Xiangyu Zhang, Shaoqing Ren and Jian Sun:“Deep Residual Learning for Image Recognition” arXiv:1512.03385 [cs], (December 2015).

[3] Karen Simonyan and Andrew Zisserman:“Very Deep Convolutional Networks for Large-Scale Image Recognition” arXiv:1409.1556 [cs], (September 2014).

[4] Olaf Ronneberger, Philipp Fischer and Thomas Brox:“U-Net: Convolutional Network for Biomedical Image Segmentation” arXiv:1505.04597 [cs], (May 2015).